Kanban vs. Scrum : quand les petits débats révèlent les grands blocages

De grandes transfos peuvent achopper sur de petits détails. Les lois de Larman nous disent qu'il faut les accepter pour nous aider à aller au-delà.

Le protocole proposé par Anthropic pour permettre aux agents IA d'accéder plus simplement aux API des services applicatifs d'entreprise ou proposés par des tiers est définitivement à tester - avec toutes les précautions d'usage !

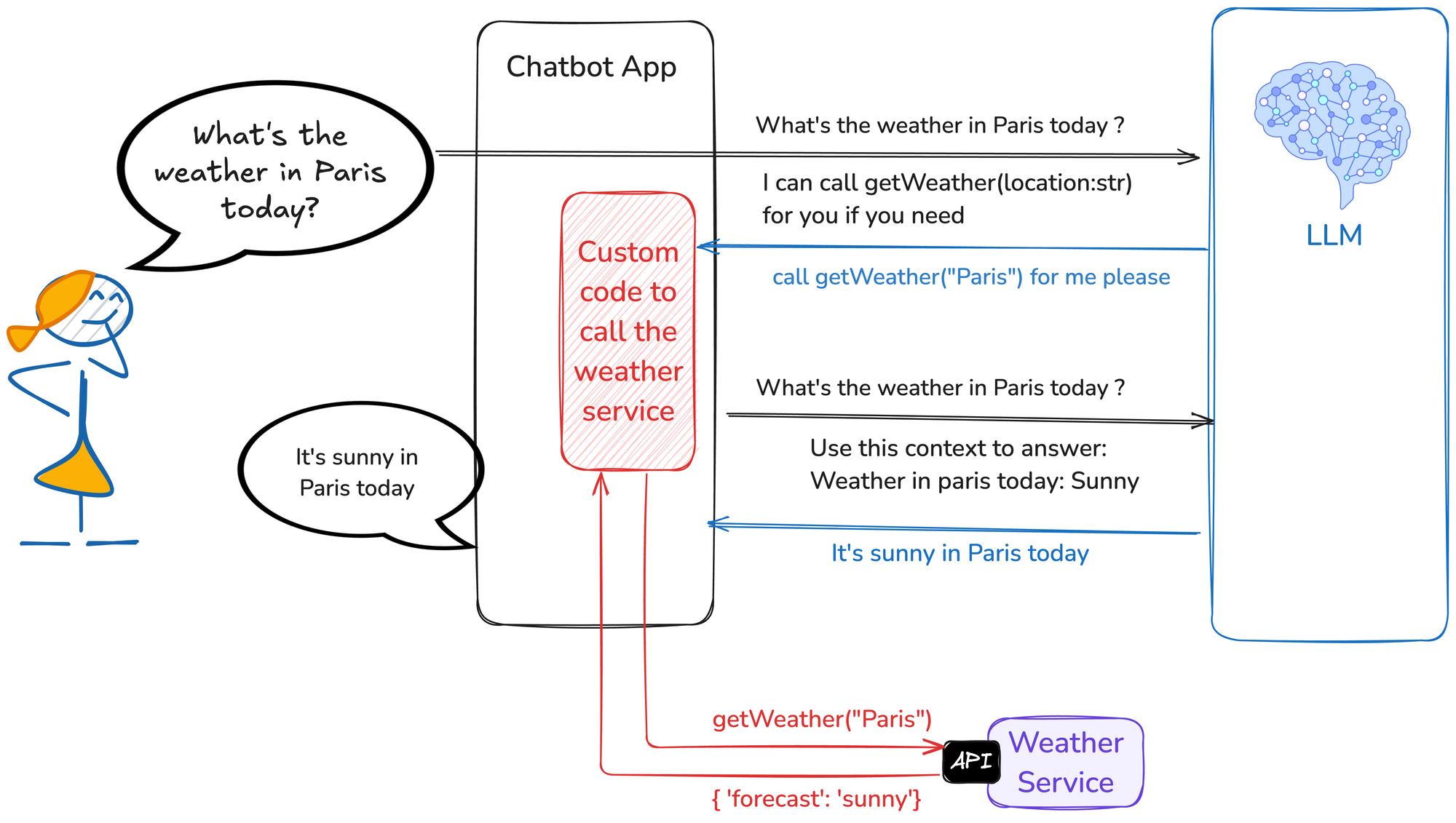

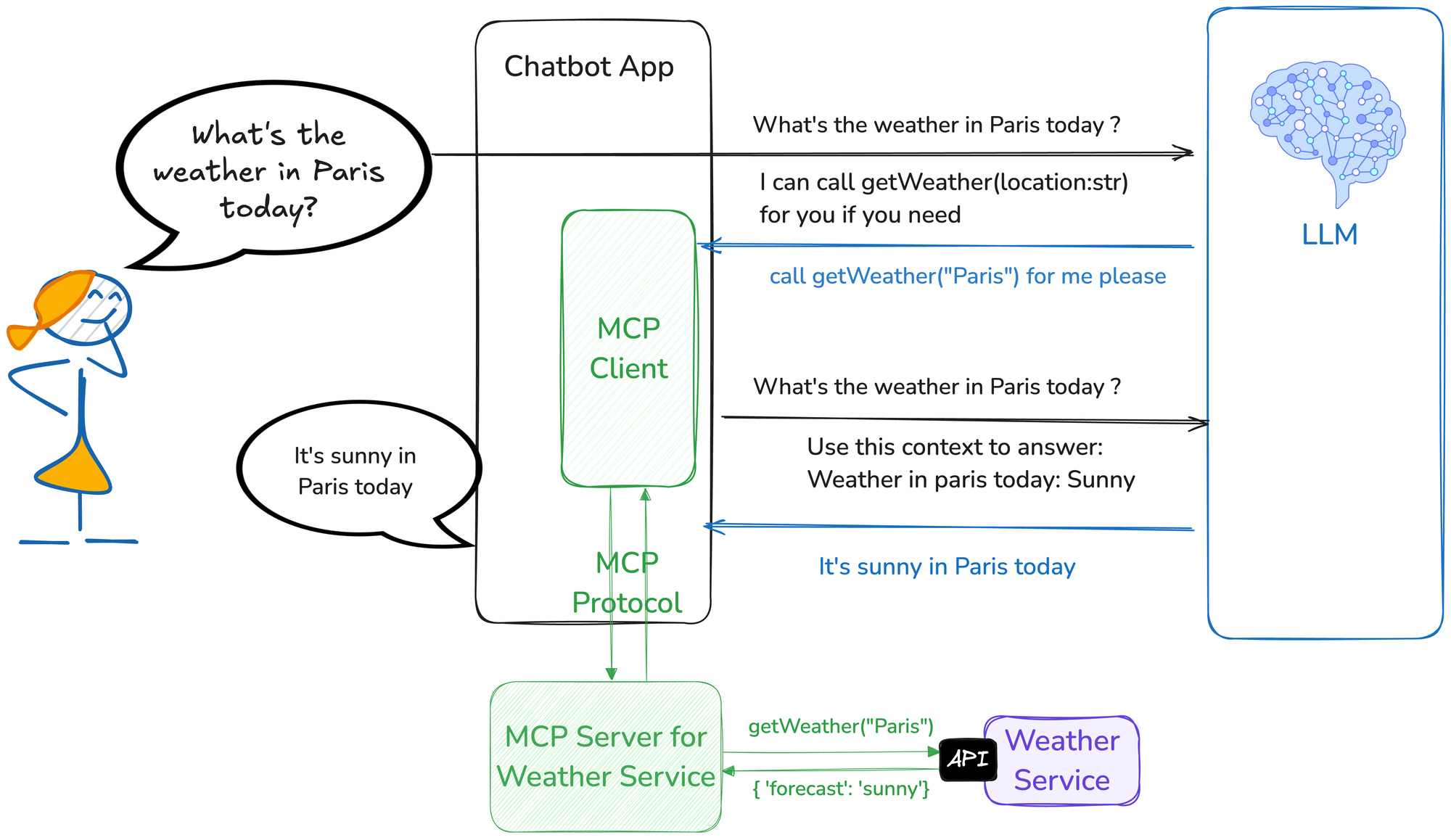

Faire interagir un LLM avec le SI d’une entreprise ou une application externe nécessite de passer par une API. Deux mauvaises solutions s’offrent alors :

Le principe du “Model Context Protocol” consiste à publier des serveurs MCP correspondant chacun à une API spécifique, que des clients MCP pourront appeler, sans avoir besoin de connaître les spécifications de l’API.

Introduit en fin d’année dernière par Anthropic, MCP a engrangé de nombreux soutiens, dont ceux de Microsoft et OpenAI, tandis que plus d’un millier de serveurs MCP sont déjà disponibles.

À date, MCP priorise l'intégration facile au détriment de la sécurité, sans standard d'authentification, ni chiffrement de contexte, ni vérification d'intégrité des outils. Ces lacunes exposent les entreprises à des risques significatifs de fuites de données et d'intrusions. Nul doute que ces problèmes seront adressés dans les prochains mois. Inutile d’attendre pour commencer à expérimenter (avec toutes les précautions requises) !

La communauté MCP sur GitHub