MCP, le chaînon manquant entre les agents IA et les services applicatifs

- Hub Insights

- 🤖 Intelligence Artificielle

- Agents & Systèmes Agentiques

- MCP le Chainon Manquant Entre les Agents IA et les Services Applicatifs

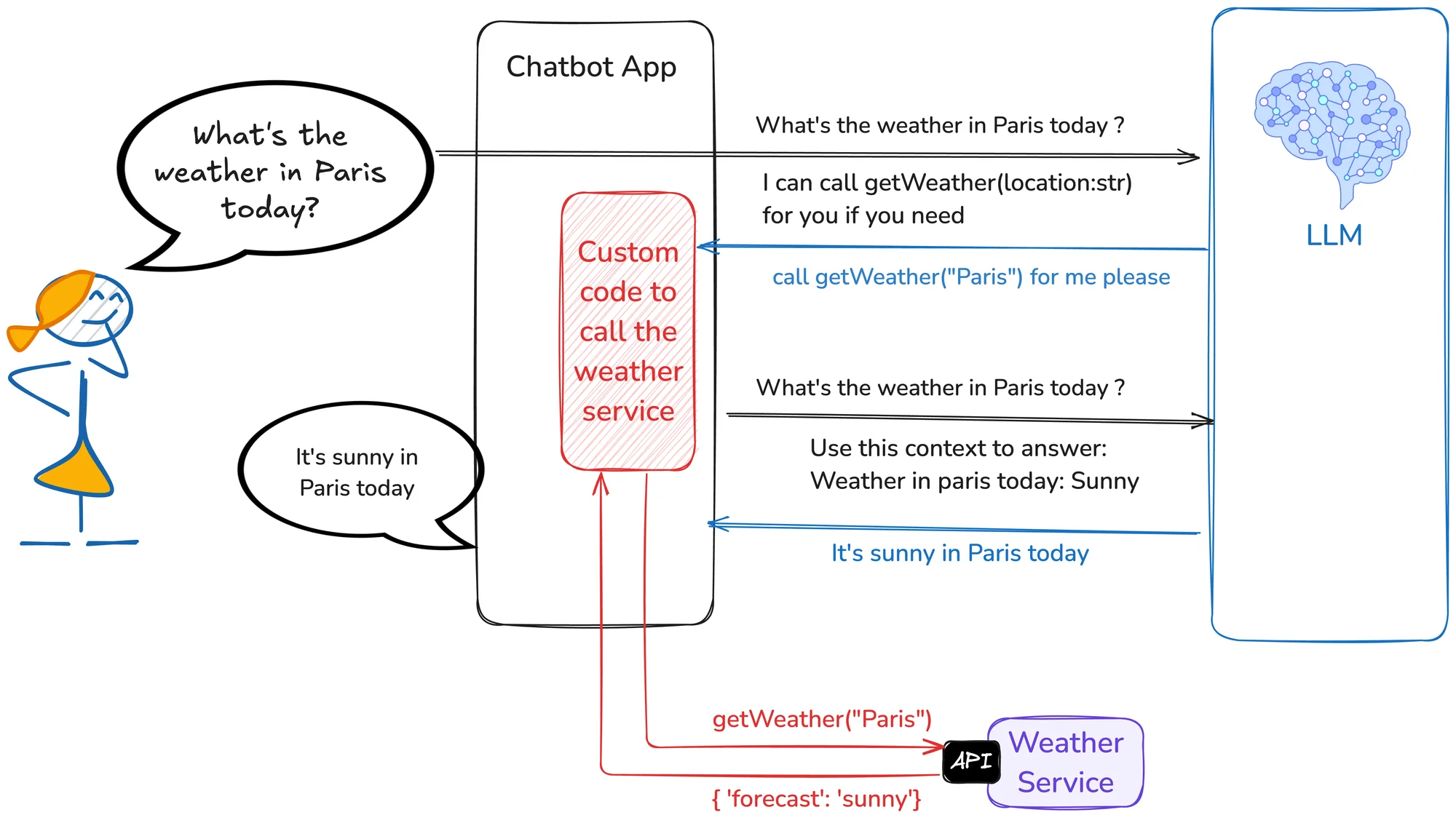

Faire interagir un LLM avec un autre service demande beaucoup d'efforts

Faire interagir un LLM avec le SI d'une entreprise ou une application externe nécessite de passer par une API. Deux mauvaises solutions s'offrent alors :

- demander au LLM de lire la spécification et de construire la requête à la volée : manque de fiabilité, insoutenable à l'échelle ;

- écrire un code spécifique pour chaque API qu'il faudra interroger : demande du temps, manque de fiabilité, difficile à maintenir, restreint l'IA.

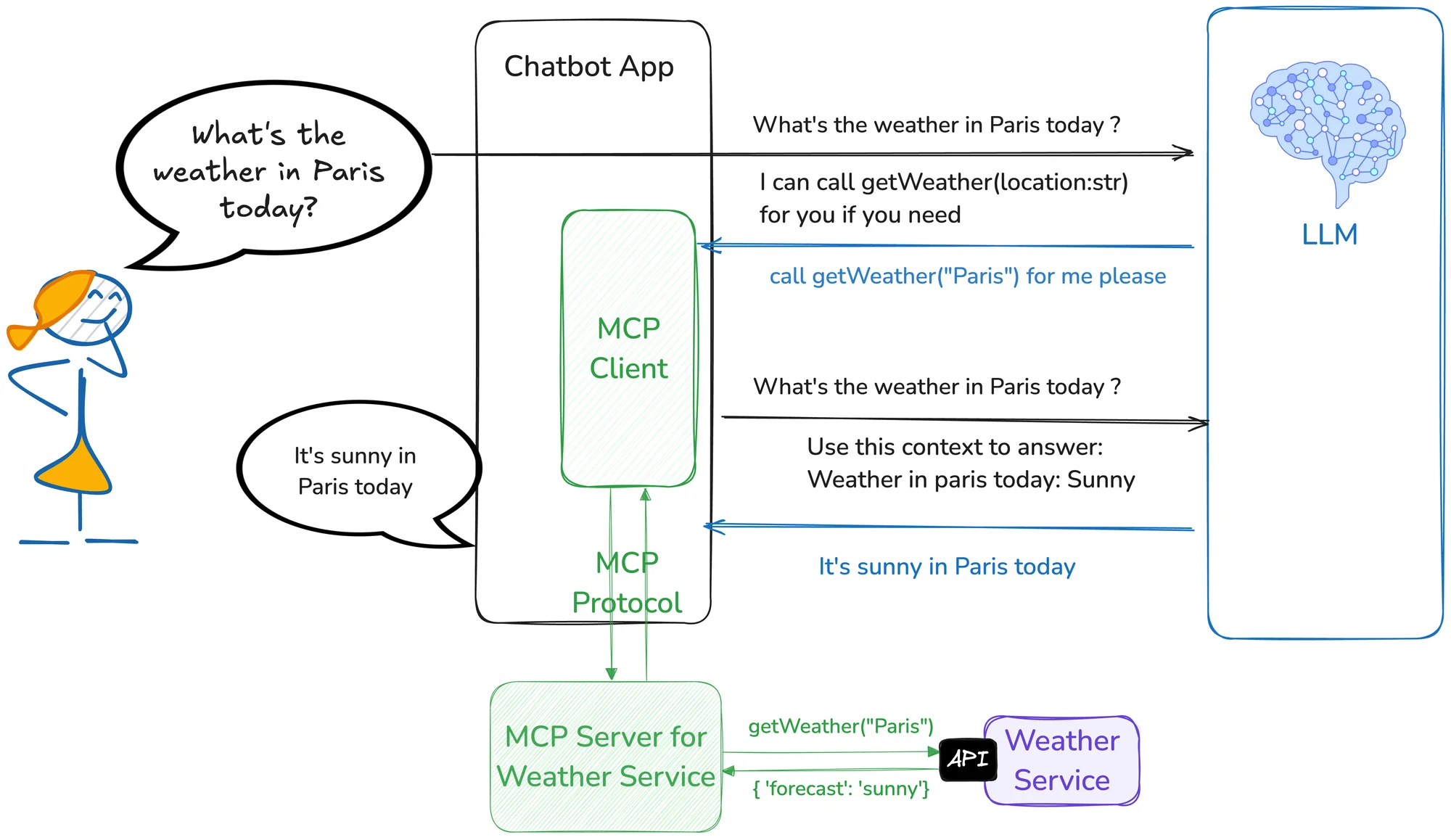

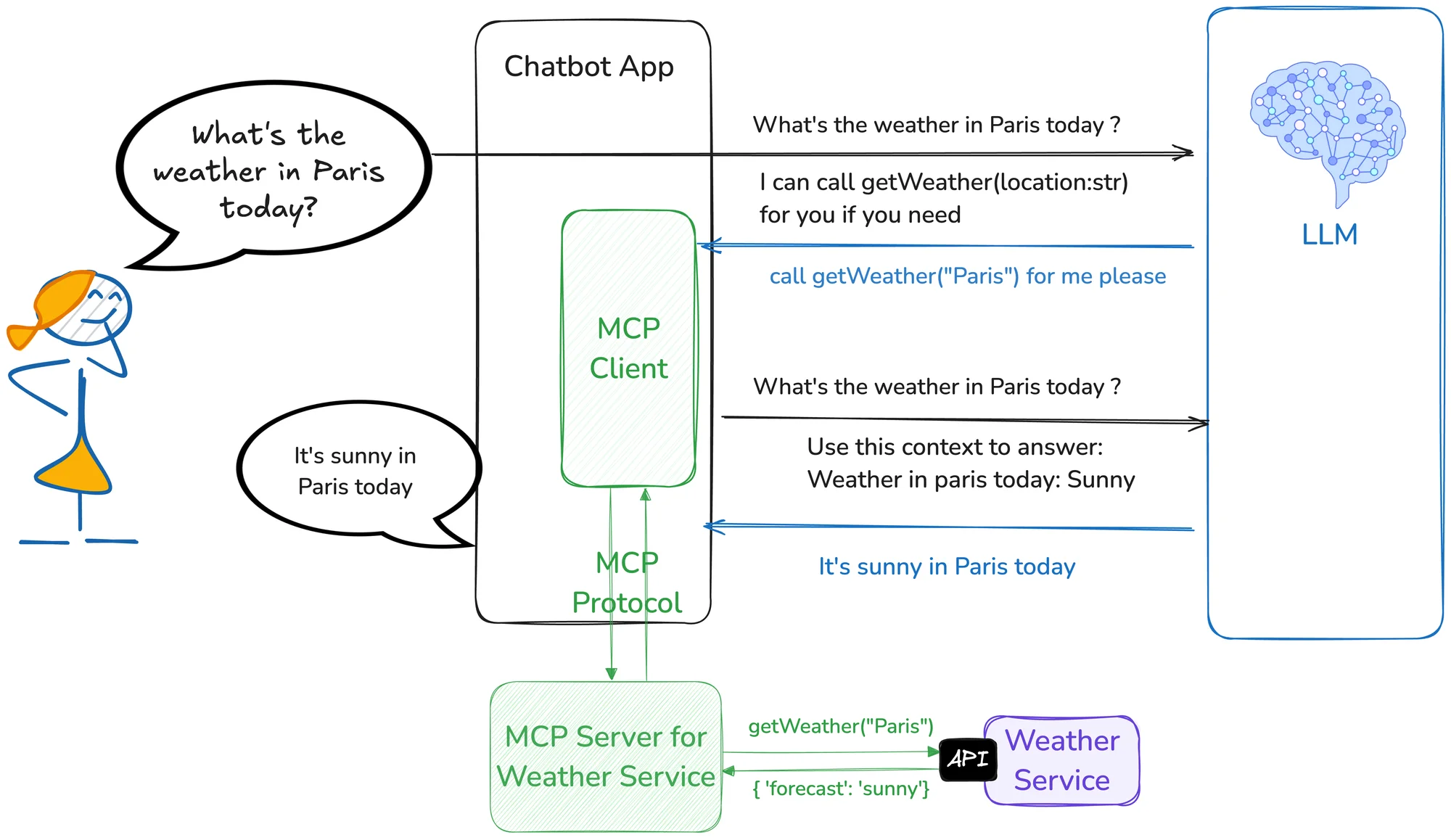

MCP permet de mutualiser ces efforts

Le principe du "Model Context Protocol" consiste à publier des serveurs MCP correspondant chacun à une API spécifique, que des clients MCP pourront appeler, sans avoir besoin de connaître les spécifications de l'API.

Introduit en fin d'année dernière par Anthropic, MCP a engrangé de nombreux soutiens, dont ceux de Microsoft et OpenAI, tandis que plus d'un millier de serveurs MCP sont déjà disponibles.

Un protocole jeune, à la sécurité incertaine

À date, MCP priorise l'intégration facile au détriment de la sécurité, sans standard d'authentification, ni chiffrement de contexte, ni vérification d'intégrité des outils. Ces lacunes exposent les entreprises à des risques significatifs de fuites de données et d'intrusions. Nul doute que ces problèmes seront adressés dans les prochains mois. Inutile d'attendre pour commencer à expérimenter (avec toutes les précautions requises) !

Continuer votre exploration

Découvrez d'autres articles du cluster agents-systemes-agentiques dans l'univers Intelligence Artificielle